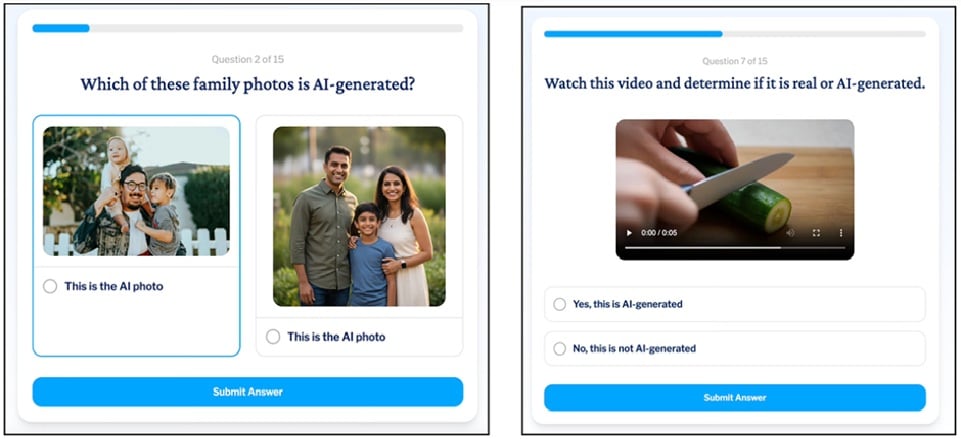

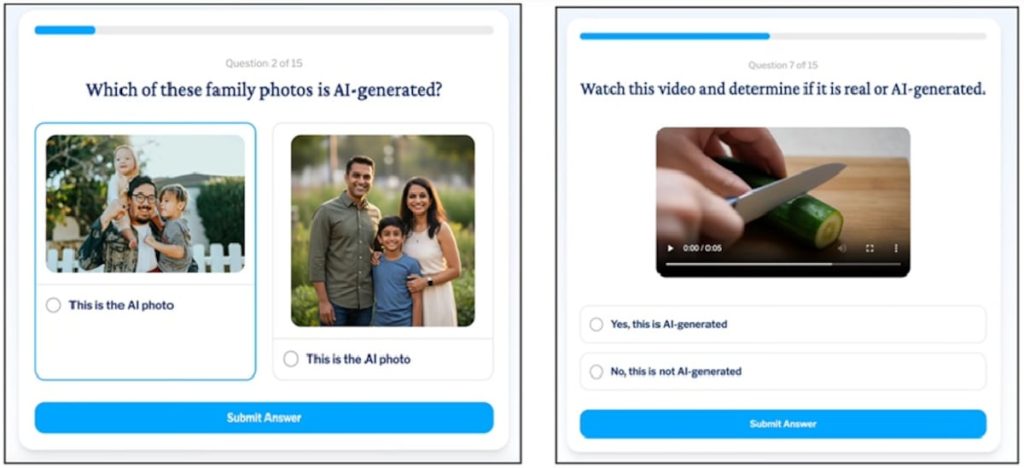

La inteligencia artificial (IA) lo invade todo. Esa biblioteca universal de contenidos que es internet está mayoritariamente creada por máquinas. “El auge de los contenidos automatizados y la interacción impulsada por bots [programas informáticos que imitan el comportamiento humano] hace que cada vez sea más difícil separar lo auténtico del ruido”, advierte Aaron Harris, director global de tecnología (CTO) en Sage, una multinacional especializada en aplicaciones de IA. The Care Side, una entidad australiana de cuidado domiciliario, ha creado un test (en inglés y accesible a través de este enlace) para poner a prueba a más de 3.000 personas. Los resultados muestran que, mientras los menores de 29 años detectan ocho de cada diez contenidos falsos con apariencia de realidad (deepfake), los mayores de 65 solo son capaces de acertar poco más de la mitad y, en muchos casos, por una respuesta sin razonar, por mero azar.El peligro de esta situación no viene solo de las posibilidades de manipulación, desinformación y condicionamiento de conductas de forma intencionada sino también de las estafas y timos a partir de creaciones artificiales, cada vez más sofisticadas. “Sin duda, el campo que más están explotando los delincuentes con la ayuda de la IA es el fraude, pues están creando campañas cada vez más convincentes. No tienen reparo en generar imágenes y vídeos de personalidades de todo tipo y cada vez resulta más difícil identificar lo que es real o fraudulento. Estamos viendo vídeos muy bien en generados con unas voces idénticas a las personas que suplantan”, destaca Josep Albors, responsable de Investigación y Concienciación de ESET España, durante la última edición de los premios de comunicación de esta compañía global de ciberseguridad.Este tipo de fraude lo ha experimentado personalmente Hervé Lambert, gerente de operaciones de servicio al cliente en Panda Security, quien recibió una llamada con la voz de uno de los directivos pidiéndole una actuación sospechosa. “Colgué el teléfono, lo llamé para confirmar si era él quien había llamado y no lo había hecho”, recuerda. Porcentajes de contenidos falsos detectados según la edad de los participantes de acuerdo al estudio de The Care Side.Lambert alaba la iniciativa australiana del cuestionario al que se ha sometido él, mayor de 50 años, y sus hijos, de entre 20 y 30 años. La mayor formación digital y dedicación a la prueba le hizo obtener mejor nota (solo tuvo un fallo) que los jóvenes, lo que le lleva a concluir que, al margen de la edad, el riesgo es general: “Creo que es un error limitar el problema a una cuestión generacional. La IA es muy inteligente y sabe perfectamente que hay contextos y momentos del día donde vamos a tener muchísima menos concentración en una cosa y eso lo utiliza muy bien”.Coincide con él Marti DeLiema, doctora en Gerontología y subdirectora de Educación en el Centro de Envejecimiento Saludable e Innovación de la Universidad de Minnesota: “La IA cambia drásticamente el panorama del fraude no solo para los adultos, sino para todos nosotros”. Lambert achaca la vulnerabilidad a “falta de conocimiento, concienciación y formación” para detectar la falsedad y el fraude, especialmente en circunstancias reales: “Cuando hacemos tres o cuatro cosas a la vez, no tenemos nuestra capacidad intelectual centrada. La evolución de las amenazas es completamente distinta desde hace 10 años y tenemos que asegurarnos que somos capaces de ver las alarmas en nuestro entorno”. En este sentido, Albors también lamenta la pereza de los usuarios para contrastar en fuentes fiables los contenidos que reciben o a los que acceden.DiLiema matiza la capacidad preventiva de la formación y añade una consecuencia imprevista de esta en el estudio de The Care Side. “No estoy segura de que la educación sobre la IA evite la desconfianza y, de hecho, sospecho que puede ocurrir el efecto contrario: cuanto más sepas sobre la IA, mayor desconfianza sentirás hacia la comunicación digital. Quizá un poco de cinismo sea en realidad protector”.Esta desconfianza ha llevado a Lambert a establecer con sus hijos una palabra clave secreta para garantizar que sus comunicaciones son reales si necesitan algo durante sus viajes y a devolver la llamada para asegurarse de que la petición es real y proviene efectivamente de uno de ellos. Hay herramientas para detectar la participación de la IA en cualquier contenido, algunas especializadas para docentes, pero Lambert considera que son insuficientes: “Limitan el riesgo, pero no lo van a eliminar”. Por eso insiste en la “educación en escenarios reales para saber qué hacer y cuándo actuar”. “En este momento, creo que estamos todos superados e incluyo a los desarrolladores de la IA y los que vivimos en este mundo de la ciberseguridad. Los delincuentes son muy listos, rápidos y hábiles. Además, no tienen límites presupuestarios ni de tiempo ni, por supuesto, respetan las normas”, lamenta. Claves para detectar y evitar el fraude con IAEn términos generales, hay formas de detectar los contenidos falsos verificando la información con fuentes solventes, como los medios de comunicación consolidados, según apunta Albors, desconfiando del contenido con alta carga emocional o no solicitado, revisando las direcciones (URL) de internet o confirmando con allegados o directamente con las fuentes de las que parece proceder el mensaje, como hace Lambert con sus hijos.Pero también hay pautas específicas según la naturaleza de los mensajes falsos que detalla el estudio de The Care Side:Texto. Ante los mensajes escritos hay que desconfiar de saludos genéricos, como “estimado cliente”, que no especifique el nombre del destinatario; no caer en las trampas de plazos urgentes, como los mensajes “solo queda uno” o “compra antes de una hora”; evitar aportar información personal, contraseñas o realizar transferencias de dinero sin verificar con el solicitante; y releer el contenido en busca de frases erróneas o poco naturales.Imagen. Aunque cada vez son más indistinguibles, se pueden detectar las creadas con IA observando si en los rostros hay simetrías inusuales o dientes y reflejos oculares extraños, si las manos presentan malformaciones o están borrosas, si las sombras y reflejos son coincidentes con el escenario, si la piel o la ropa presenta texturas demasiado suaves o si se muestran en el fondo elementos de arquitectura o mobiliario urbano impropios.Audio. Los mensajes de voz con IA suelen presentar pausas antinaturales o ritmos robóticos en el habla, cambios repentinos en la voz, ruidos de fondo inusuales o tonos emocionales no coincidentes con el contenido. Las voces artificiales en una conversación también reaccionan de forma distinta a las de una persona (respuestas imprecisas o descoordinadas con el flujo normal) y carecen de las imperfecciones humanas (errores de pronunciación o balbuceos). Vídeo. A las creaciones audiovisuales se le pueden aplicar las características de los dos apartados anteriores y sumarle observaciones de gestos faciales incoherentes con la secuencia, imprecisión en los movimientos de labios y párpados o expresiones y movimientos antinaturales.

¿Sabe distinguir un ‘deepfake’? Un cuestionario para discernir lo real de lo artificial desvela mayores problemas con la edad | Tecnología

Shares: